De manière générale, lorsque nous souhaitons identifier l’origine d’un mal qui affecte la société (un attentat, une crise économique, un chômage massif…), une question qui vient naturellement à l’esprit est la suivante : « à qui profite le crime ? ». Nous pensons spontanément que remonter le fil de cette interrogation amènera à identifier la cause du fléau contre lequel on souhaite lutter. Bien souvent, il s’agira d’identifier un groupe d’individus qui aura intentionnellement provoqué le mal : telle classe sociale œuvre à la perpétuation des inégalités ou tel groupe a conspiré pour provoquer tel évènement à des fins politiques.

Les dangers que l’on associe à l’utilisation généralisée des algorithmes ont cela d’intéressant qu’ils représentent une catégorie de dangers qui mettent à mal une telle façon de raisonner. Si l’utilisation malveillante des algorithmes peut bien sûr exister, ces dangers (bulles de filtrage, perpétuation d’inégalités dans le système judiciaire, diffusion virale d’information douteuse…) ont cela de particulier qu’ils sont généralement aux antipodes d’une telle lecture « intentionnelle ».

Les algorithmes ont été appelés « Weapons of Math Destruction » dans l’ouvrage éponyme de Cathy O’Neill. Ils ne sont pas le fruit d’une conspiration, mais plutôt le résultat d’interactions complexes, souvent imprévisibles, entre la rationalité aveugle des lignes de code algorithmiques, les données imparfaites qui les nourrissent, et les étroites limites de la rationalité humaine. Ainsi, il arrive que des algorithmes conçus avec de bonnes intentions soient à l’origine de véritables fléaux sociaux, à l’insu de leurs concepteurs et de leurs utilisateurs. De telles situations sont contre-intuitives, car on ne trouve pas d’agent malveillant qui œuvre en coulisses.

Désigner un coupable à l’origine de nos maux permet de passer à l’action

Pourquoi avons-nous spontanément tendance à croire qu’à l’origine de nos maux se cache un agent animé par une volonté de nuire ? Plusieurs mécanismes psychologiques permettent d’en rendre compte, et notamment certains biais cognitifs – des erreurs systématiques de raisonnement. L’humain tend naturellement à raisonner de manière téléologique, c’est-à-dire à penser que si un évènement se produit, celui-ci se produit dans un but particulier. Par extension, nous pourrons avoir tendance à croire que l’évènement a été voulu par un agent conscient, ce dernier fut-il invisible. Ce type de raisonnement se retrouve dans nombre de croyances, allant du créationnisme à diverses théories du complot. Tout particulièrement pour expliquer les évènements ayant des conséquences négatives, il semble que nous privilégions les causes intentionnelles aux causes accidentelles.

On parle de « biais d’intentionnalité » pour désigner cette tendance à spontanément chercher une intention consciente derrière les évènements. Si dans nombreux cas ce biais nous amènera à des conclusions hâtives et souvent fautives, il comporte un avantage important : il permet d’identifier clairement et rapidement un responsable, et donc d’agir contre celui-ci là où une réflexion plus fine, scientifique, prendra davantage de temps… temps durant lequel le coupable intuitivement identifié pourra continuer de nuire ! Dans la mesure où le biais d’intentionnalité (et le raisonnement téléologique de façon générale) s’observe dès la petite enfance, on peut supposer qu’il est issu de notre histoire évolutive.

Ainsi, le biais d’intentionnalité comporte une utilité adaptative qui était d’autant plus grande à l’époque où les sociétés étaient à la fois moins complexes et plus violentes. La désignation d’un coupable (qui sera bien souvent un groupe social particulier, perçu comme une entité monolithique : les élites, les banquiers, Big Pharma, les multinationales, les immigrés, les Juifs…), est un puissant facteur de mobilisation collective. Outre cet intérêt adaptatif, il est de plus en plus clair que les expressions conspirationnistes du biais d’intentionnalité ont d’autant plus de chance d’apparaître à la suite d’un évènement générant de la peur et de l’incertitude. La désignation d’un coupable permet également de soulager l’inconfort mental provoqué par cet état d’incertitude et de peur.

L’utilisation généralisée des algorithmes est adossée à une série de phénomènes qui préoccupent de plus en plus les chercheurs en sciences sociales : dérégulation généralisée du marché de l’information, isolement des individus dans des bulles idéologiques, viralité d’informations douteuses, perpétuation de stéréotypes (notamment par les moteurs de recherche)… Mais également, dans des registres plus dramatiques, krachs boursiers et décisions de justice iniques à l’égard des minorités. Tous ces phénomènes ont en commun qu’ils n’ont pas été délibérément provoqués par un agent conscient. Il s’agit d’effets émergents, c’est-à-dire des effets collectifs plus ou moins imprévisibles qui découlent de l’agrégation d’actions individuelles non concertées – cette dernière précision étant d’une importance capitale.

Un algorithme peut-il être dangereux ?

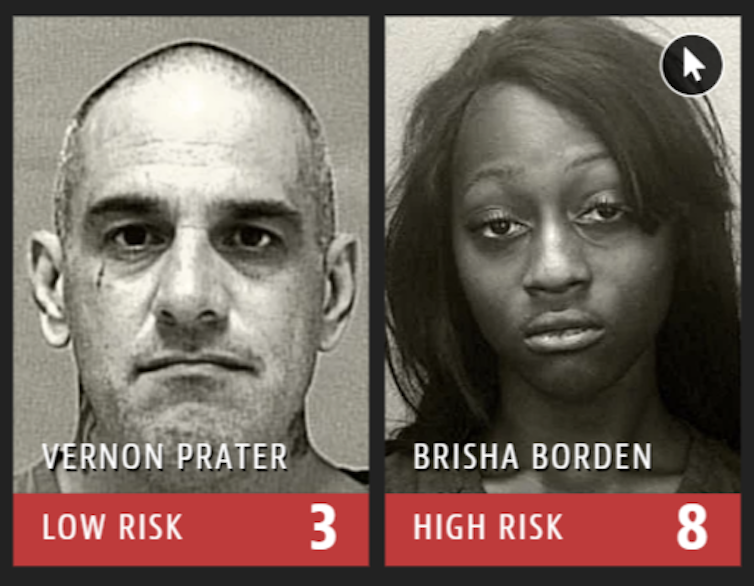

Dans certains cas, il arrive même que ces effets émergents aillent directement à l’encontre des bonnes intentions qui sous-tendaient la conception des algorithmes. Prenons un exemple : l’utilisation d’algorithmes calculant un « risque de récidive » dans les procédures de justice aux États-Unis. Il a été mis en évidence qu’à casier judiciaire égal, l’algorithme judiciaire COMPAS jugeait les prévenus noirs davantage susceptibles de récidiver que les prévenus blancs.

Les concepteurs de cet algorithme étaient-ils secrètement racistes et désireux de perpétuer les inégalités raciales ? Nous n’avons guère de raison de le supposer. En fait, à l’origine, l’un des arguments en faveur de ces procédures automatisées était justement qu’elles permettraient de rendre plus objective la décision judiciaire, et d’évacuer les éventuels penchants racistes des juges et des jurés. Naturellement, les concepteurs de l’algorithme ont exclu la couleur de peau des informations utilisées pour calculer le risque de récidive criminelle. Le problème dénoncé par les critiques des algorithmes judiciaires est que certains des « facteurs de risque » y renvoient indirectement.

Par exemple, on sait que certains quartiers précaires et en proie à une forte criminalité sont majoritairement habités par des populations afro-américaines. Or, habiter un tel quartier constitue un « facteur de risque » selon l’algorithme ; dès lors, avoir pour origine un « quartier sensible » reviendra à condamner plus lourdement une personne de couleur qu’une personne blanche pour un même crime. Ainsi, l’utilisation de l’algorithme, au lieu de réduire les inégalités, se mettrait au service de leur reproduction ! De plus, elle y ajoute un vernis d’objectivité scientifique qui peut-être plus difficile à combattre que des préjugés racistes.

Notre cerveau semble cablé pour rechercher des coupables derrière les maux qui frappent la société. Cette intuition, si elle peut dans nombre de cas s’avérer fautive ou à tout le moins non fondée, comporte certains avantages : elle encourage dans certains cas à se mobiliser, et à agir contre le coupable présumé – quand bien même celui-ci serait en réalité innocent. Néanmoins, le cas des algorithmes – des « weapons of math destruction » – rappelle que quand bien même nous peinons à imaginer qu’un problème social puisse advenir en l’absence d’une volonté malveillante, de telles situations sont bien réelles, et constituent des enjeux majeurs pour la société. Concernant les algorithmes, on peut par exemple s’interroger sur la nécessité de rendre leur fonctionnement moins opaque. En effet, cette opacité empêche leur analyse critique, et par la même la responsabilisation de leurs concepteurs – quand bien même ceux-ci seraient animés par les meilleures intentions qui soient.

Article publié sur le site : https://theconversation.com/algorithmes-ou-sont-les-dangers-120543

Auteur : Kenzo Nera - Doctorant en psychologie sociale, Université Libre de Bruxelles

Cet article est publié à partir de The Conversation sous licence Creative Commons.

Dernière modification le mercredi, 28 septembre 2022