« Nous devons exterminer les rats. Les [Groupe religieux] sont dégoûtants, [Groupe religieux] devraient être punis. Nous ne faisons pas assez pour nous débarrasser de ces sales bêtes. »

Début septembre, YouTube dressait un bilan d’étape prometteur, annonçant le retrait sur trois mois (entre avril et juin 2019) de plus de 100 000 vidéos et 17 000 chaînes et plus de 500 millions de commentaires compromettants.

Les deux plates-formes emboîtaient le pas à Facebook qui avait supprimé une année auparavant, après une alerte du blog consacré à la sécurité en ligne, KrebsOnSecurity, près de 120 groupes de discussion privés rassemblant plus de 300 000 membres faisant l’apologie d’activités illicites.

Les réseaux sociaux tiennent manifestement à donner des gages de bonne volonté pour contrebalancer les effets d’une des faces les plus hideuses du cyberespace. En sont-ils seulement capables ?

Prise de conscience

Récemment, on a vu une multiplication de pressions institutionnelles et réglementaires visant à lutter contre la haine en ligne, comme pour la loi Avia en France, dont la proposition a été adoptée par l’Assemblée nationale en juillet dernier (sans pour autant faire l’unanimité). Cette dernière impose aux plates-formes de retirer un contenu en 24 heures. En Allemagne, la loi NetzDG qui soumet les réseaux sociaux aux mêmes délais sous peine d’amendes pouvant atteindre jusqu’à 50 millions d’euros.

Ces mesures ne sont sans doute pas étrangères à la prise de conscience des propriétaires des réseaux sociaux face à ces montées haineuses.

Mais cela peut-il endiguer un phénomène de plus en plus accru ? Plus de la moitié des Américains ont déclaré avoir été victimes de discours haineux et de harcèlement en 2018. En Europe, 75 % des personnes qui suivent ou participent à des débats en ligne ont été témoins ou ont été victimes d’abus, de menaces ou de contenu haineux.

L’IA à la rescousse ?

Si de nombreux pays commencent à s’en préoccuper, c’est que le processus de cyberviolence a changé de temporalité et d’espace aussi. Au début de l’aventure Internet, la diffusion des discours haineux était à sens unique, transposée exclusivement de la vie réelle vers le numérique.

Aujourd’hui, sans pour autant faire disparaître la première, c’est la tendance inverse qui est constatée, souvent avec des prolongements tragiques, comme pour les attentats de Christchurch où un suprématiste blanc filmait en direct sa tuerie ou pour le meurtre de la députée britannique Jo Cox : 50 000 tweets célébraient sa mort.

Cette avalanche de chiffres communiqués par les réseaux sociaux traduit aussi les spectaculaires avancées permises par l’intelligence artificielle (IA) et le champ de la linguistique informatique (comme pour le traitement automatique du langage naturel, connu sous l’acronyme TALN).

De manière opérationnelle, celles-ci s’expriment à travers le déploiement d’une logistique d’apprentissage par la machine (machine learning) pour la traque de messages haineux en mobilisant des algorithmes comme les « K plus proche voisin », qui vont même jusqu’à prédire, en fonctionnant sur le modèle des prédicteurs textuels de nos smartphones, l’orientation de futurs contenus, ou encore ceux de la « reconnaissance d’entités nommées » (Named Entity Recognition, NER), programmes qui permettent d’identifier et de classer plus efficacement l’information textuelle : le processus va consister, dans une chaîne de texte par exemple à identifier un certain nombre de mots clefs pertinents : lieux, personnes, organisations.. Un arsenal pour lequel les GAFA se livrent à de féroces batailles de suprématie

Traiter la masse de renseignements sur chaque profil

Les données sur Internet renvoient à une pléthore de renseignements qui peuvent aider à mieux cerner le profil : contributions des internautes, mais aussi les données de navigation ou journaux d’activités (appelés logs dans le jargon), ou encore les gisements du web sémantique, une extension du World Wide Web qui a ouvert de nouvelles perspectives pour Internet et ses nombreuses applications, en améliorant par rapport à l’architecture originelle inventée par Tim Berners-Lee, la qualité des données interprétables par les machines.

Intensément investi par la recherche ces dernières années, le développement d’outils capables de prédire et d’identifier ce type de contenu commence présentement à porter ses fruits. La puissance des systèmes automatisés a permis à YouTube par exemple de détecter puis de supprimer plus de 87 % des 9 millions de vidéos au cours du deuxième trimestre 2019.

Les limites de l’éthique numérique

Tout n’est pas gagné pour autant. Les efforts de déploiement d’une éthique numérique continuent de se heurter à de nombreux écueils.

Une partie des difficultés tient aux discussions interminables sur le caractère privé Vs public des données personnelles ou à l’équilibre introuvable entre la lutte contre les discours haineux et la préservation de la liberté d’expression comme s’en défendait fin août 2019, la PDG de YouTube dans une lettre à son audience.

C’est d’ailleurs l’alibi brandi par la filiale de Google pour justifier son refus de bloquer la vidéo intitulée « Les Juifs admettent avoir organisé le génocide blanc » postée par David Duke, militant d’extrême droite américain et proche un moment du KKK ou encore la réouverture de deux comptes qui auraient inspiré le terroriste de Christchurch.

Un anonymat opportun

Mi-aout 2019, la ligue anti-diffamation, une ONG de lutte contre l’antisémitisme, constatait que 29 chaînes au moins sur YouTube relevaient de la catégorie antisémites et suprémacistes blancs. L’anonymat permis par de nombreuses plates-formes complique également la traque.

Il constitue un environnement favorable dans ce que les travaux en sociologie et/ou en psychologie décrivent en tant que propension à s’autoriser en ligne des comportements qu’on n’accepterait pas dans la vie réelle ou ce que John Suler nomme l’« effet de désinhibition ».

La plate-forme « Secret » créée en 2013 par des anciens cadres de Google, et dont le modèle économique s’appuyait en grande partie sur l’anonymat des messages, en a fait les frais, fermée au bout de deux ans d’activité car accusée de favoriser la cyberintimidation ou de ne rien faire pour prévenir le risque suicidaire chez les adolescents en dépit de la multiplication des demandes d’aide des victimes.

Les risques du tout technologique

Le tout technologique n’est pas non plus une garantie de résultat dans la lutte contre la cyberhaine. Les approches mobilisées peuvent contribuer à amplifier des biais, signalant par erreur des messages comme étant offensants ou haineux. Une nouvelle recherche montre d’ailleurs que les principaux modèles d’intelligence artificielle avaient 1,5 fois plus de risques de qualifier « d’offensants » les tweets rédigés par des Africains-Américains !

Les impératifs de contextualisation, les vocabulaires pouvant concerner des situations non liées à la haine, tiennent avant tout à la qualité des répertoires de mots ou des catégorisations de données établis, lesquels ne sont jamais suffisamment exhaustifs.

Twitter a par exemple a accidentellement suspendu un compte parce que son algorithme a buggé sur une photo de profil où Captain America frappait un nazi.

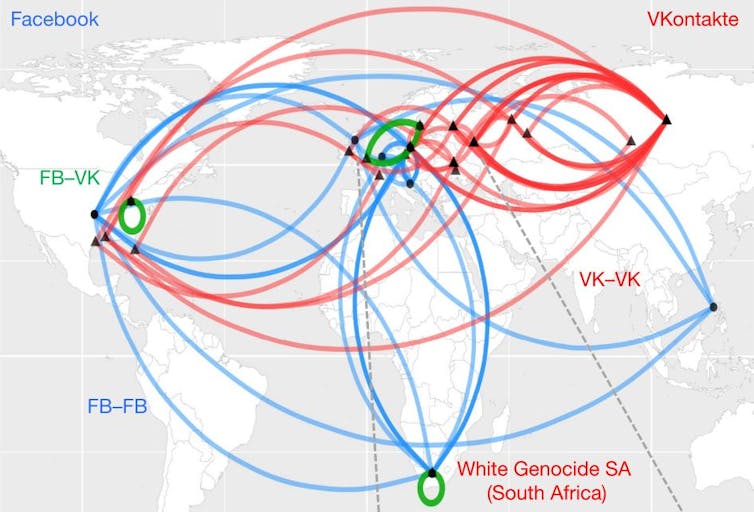

Plus préoccupant, la récente recherche menée par l’équipe du professeur Neil Johnson, du département de physique de l’université George Washington, et dont les résultats ont été publiés en août dans la revue Nature, confirme bien l’existence d’autoroutes de la haine en ligne et des grappes ou clusters solides, hautement interconnectés et auto organisées à travers différents plates-formes (Facebook, Twitter, VKontakte), pays et langues.

Ces réseaux peuvent associer une variété de thèmes haineux (antisémitisme, anti-immigrés, anti-LGBT+).

Lorsqu’ils se sentent menacés, ces systèmes ou grappes font preuve d’une surprenante résilience face aux attaques. Toute stratégie tentant d’interdire un groupe haineux en une zone A, par exemple, est vouée à l’échec dans la mesure ou la grappe se reconstitue rapidement dans une Zone B. Paradoxalement, cette « réincarnation » intervient alors mêmes que les deux zones peuvent correspondre à des plates-formes non seulement indépendantes mais concurrentes (Facebook Vs VKontakte dans le cas d’espèce), et que les groupes de la haine peuvent être éloignés géographiquement, linguistiquement et culturellement.

Quelle méthode face aux grappes de la haine

Compte tenu de leurs complexité, Johnson et son équipe préconisent d’ailleurs entre autres approches d’interdire, au hasard, de petits échantillons de la grappe au lieu de cibler une grappe tout entière sous peine d’échec.

Cette solution tranche avec celles adoptées actuellement par les plates-formes, lesquelles consistent soit à exclure individuellement les contrevenants soit à bannir des groupes entiers de comptes haineux. On l’a bien compris, dans ce débat la question est de savoir si la méthode est la bonne.

Mais, au-delà il s’agit aussi de s’interroger sur l’ensemble des valeurs véhiculées sur ces plates-formes.

En effet, ce sont les nouvelles perceptions des notions mêmes de démocratie qui paraissent désormais en jeu. Aux États-Unis, par exemple, quatre jeunes sur dix seulement considèrent que le gouvernement devrait sévir contre des contenus offensants à l’égard des minorités.

Comment alors évaluer les stratégies de lutte sans les croiser avec les transformations, pour le meilleur et malheureusement pour le pire aussi, de nos sociétés contemporaines ?

Mohamed Benabid, Docteur en Sciences de gestion, Docteur en Sciences de l'information et de la Communication, Université Paris 8 -Vincennes Saint-Denis chercheur associé l'ENCG Casablanca, Université Hassan II Casablanca – AUF

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

Dernière modification le mercredi, 28 septembre 2022